AI-láz a szervertermekben – az Nvidia új gyorsítói elárasztják Európát

Szerző: Napi Hírek szerkesztősége |

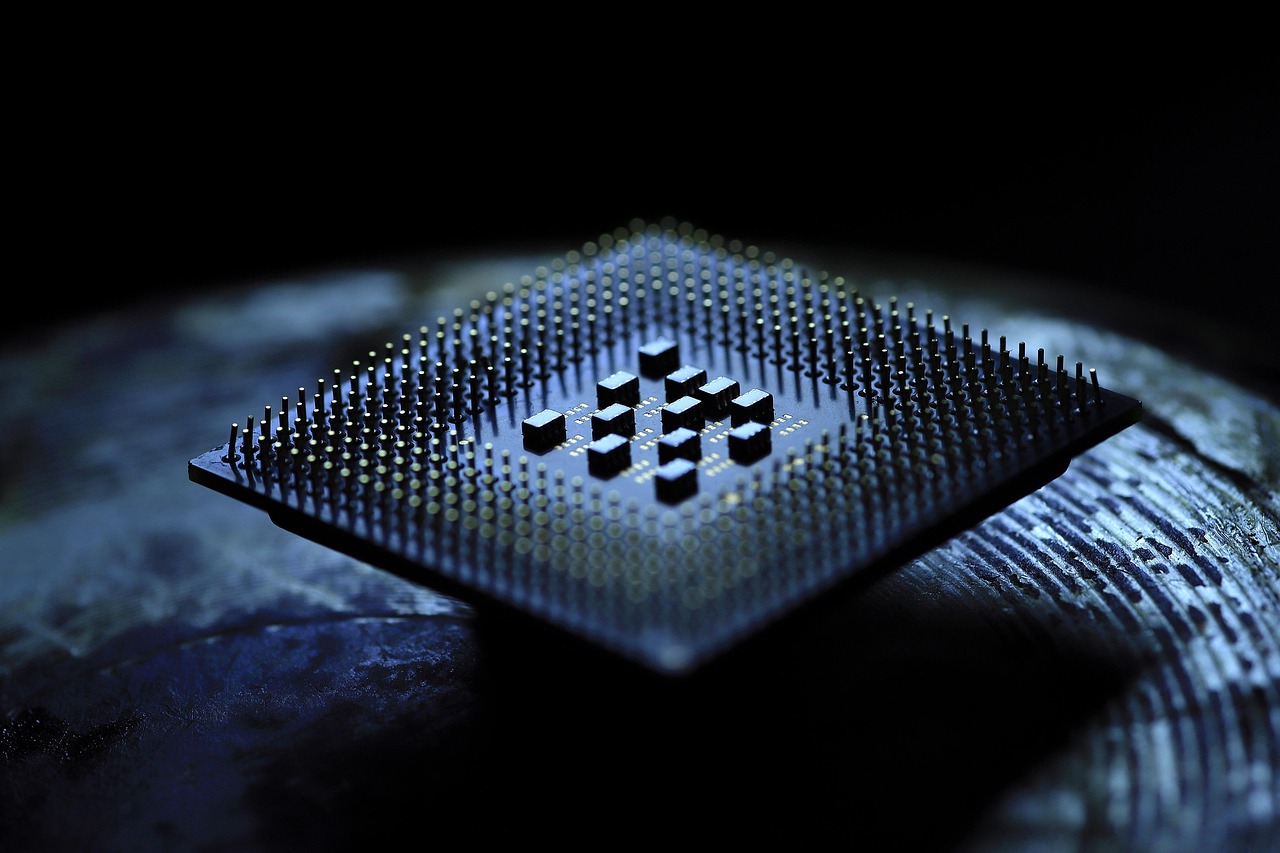

A Nvidia 2025 nyarán hivatalosan is elindította Blackwell AI gyorsító architektúrájának tömeges kiszállítását. Az új chipek kevesebb energiával háromszor akkora teljesítményt nyújtanak, mint az előző generációs Hopper sorozat. Az új rendszer már a Google, Meta és Amazon AI rendszereiben is működik.

Milyen cégek használják?

- Google – Gemini Ultra 2 tanításához Blackwell GPU farmokat épít

- Meta – AI videógenerátorokat futtat vele (pl. Emu Video)

- Amazon – AWS új Trainium 3 gyorsítója Blackwell-alapú

- Magyar vonatkozás: A Baranya AI DataHub is megkezdi a Blackwell bevezetését saját kutatási klaszterében

Mit tud a Blackwell?

Az új Nvidia gyorsító:

- 4nm-es gyártástechnológia TSMC-nél

- 20 petaflops FP4 számítási kapacitás

- 256 GB HBM4 memória

- PCIe 6.0 és NVLink 5 támogatás

Mit jelent ez az AI jövője szempontjából?

A generatív AI (pl. ChatGPT, Gemini, Claude) egyre több erőforrást kíván. A Blackwell gyorsítók lehetővé teszik, hogy modellek töredék idő alatt tanuljanak, és a futtatási költségek akár 40%-kal is csökkenhetnek. Ez kulcsfontosságú lehet a kisebb cégek AI-stratégiájában is.

„A Blackwell chipek lehetővé teszik a valós idejű többnyelvű AI-értelmezést és képgenerálást egyidejűleg” – nyilatkozta Jensen Huang, az Nvidia vezérigazgatója.